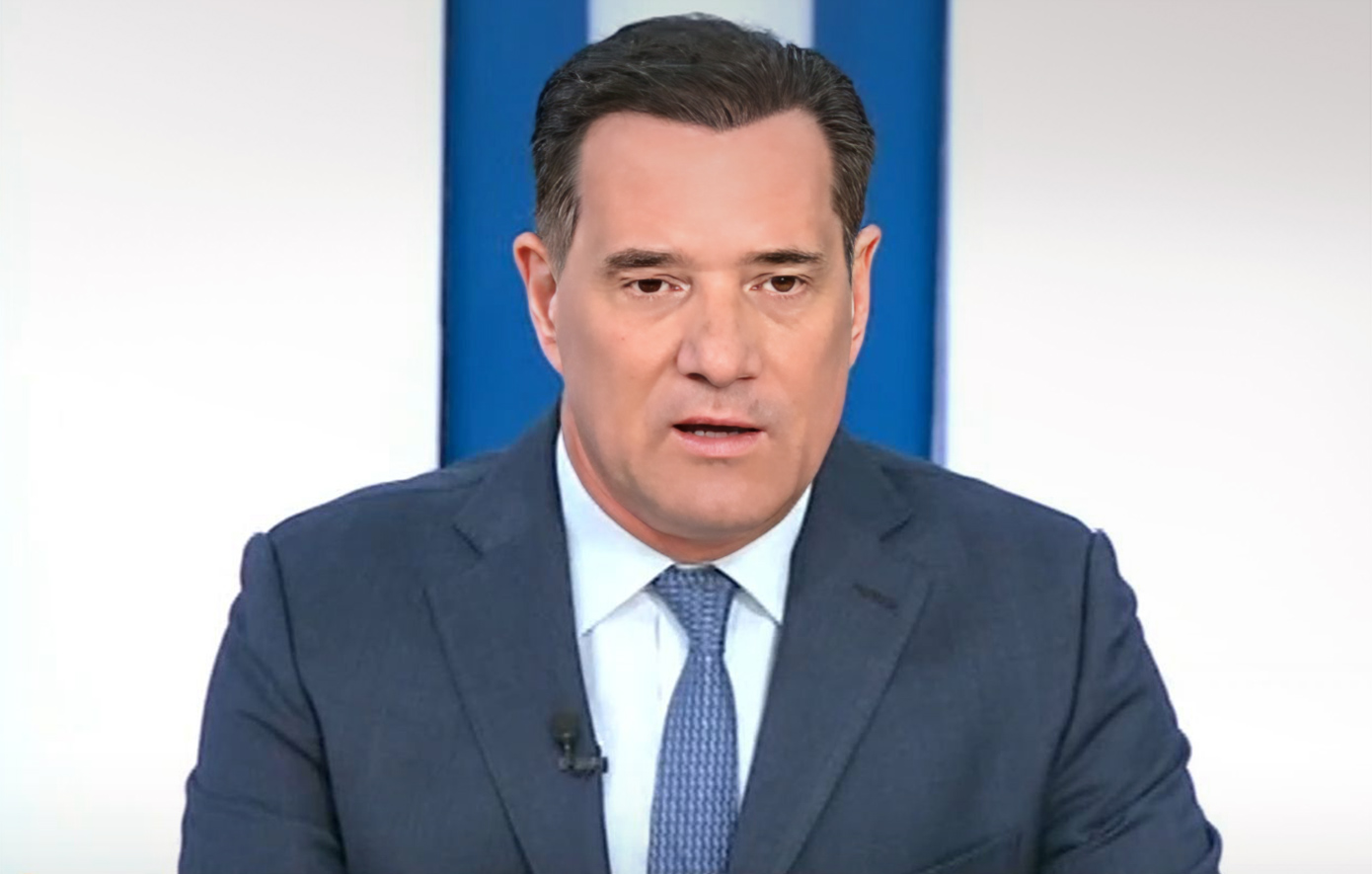

Είναι σαν να βρισκόμαστε σε δύο παράλληλα σύμπαντα. Το πραγματικό και το ψηφιακό. Εκεί όπου για να ζήσουμε αναπνέουμε αέρα και εκεί όπου αναπνέουμε μέσω των social media. Την ώρα που κάποιοι, και δεν είναι λίγοι, θεωρούν πως είμαστε μέρος μιας δυστοπικής παγκόσμιας τεχνολογικής καθημερινότητας, η τεχνητή νοημοσύνη αναπτύσσεται πιο γοργά απ’ ό,τι μπορεί να την παρακολουθήσει ο μέσος πολίτης. «Το θέμα είναι πού πάμε και τι είναι στο χέρι μας να διαχειριστούμε», σημειώνει ο Παναγιώτης Σαραντέας.

Ο καλεσμένος στο podcast του Newsbeast είναι υποψήφιος διδάκτορας – ερευνητής στην ηθική της τεχνολογίας και της τεχνητής νοημοσύνης στο πανεπιστήμιο της Φλόριντας, αλλά και υποψήφιος ευρωβουλευτής με τους Δημοκράτες του Ανδρέα Λοβέρδου. «Δεν μου ταιριάζει η παθητική ανάλυση. Το μέλλον εμείς το χτίζουμε. Δεν θα έρθει ένα μέλλον από κάποιους άλλους και θα είναι καλό ή κακό. Ξέρεις πόση δύναμη έχεις επάνω σου; Μπορείς να διαλέξεις το μέλλον σου», μου είπε. «Η τεχνολογία, θα ήθελα, να χρησιμοποιηθεί για να επεκτείνει τις ανθρώπινες δυνατότητες. Να επεκτείνει την ανθρώπινη ευδαιμονία. Και στον ηθικό τομέα, και στον τομέα της ελευθερίας», συμπλήρωσε.

Με τον κύριο Σαραντέα αναπτύξαμε ζητήματα που απασχολούν ολόκληρη την παγκόσμια κοινότητα και επηρεάζουν το σήμερα και το αύριο περισσότερο απ’ όσο φανταζόμαστε. Μιλήσαμε για την αφυπνισμένη αλγοκρατία, την ψηφιακή φυλακή, τους κινδύνους της τεχνητής νοημοσύνης. «Βλέπουμε να υπάρχουν και μορφές νέων κινδύνων. Η αφυπνισμένη αλγοκρατία, για παράδειγμα. Φαίνεται πως υπάρχει μια αφιλελεύθερη προσέγγιση στο πώς θα είναι η τεχνητή νοημοσύνη στη συζήτηση και στην παρουσίαση εικόνων και σε διάφορα άλλα εμφανή θέματα, ενώ ο Μασκ λέει ότι αυτό μπορεί να μας οδηγήσει σε ένα καθεστώς ψηφιακού αποκλεισμού. Σε μια ψηφιακή φυλακή και ψηφιακή απομάκρυνση από την κοινωνικο-οικονομική και πολιτική σκηνή κάποιων ανθρώπων», τόνισε ο Παναγιώτης Σαραντέας.

«Όταν μια προσωπικότητα όπως ο Έλον Μασκ εκφράζει τις ανησυχίες του για την τεχνητή νοημοσύνη, τον παίρνεις στα σοβαρά. Την ώρα που οι άλλοι πάνε με χίλια για να βγάλουν πρώτοι το προϊόν, ο Μασκ έχει προτεραιότητα να προσπαθήσει να αλλάξει την πιθανότητα να φέρουμε ένα κακό αποτέλεσμα», πρόσθεσε.

Ακολουθούν τα σημαντικότερα σημεία της συζήτησης

-Έχει ηθική η τεχνολογία; «Η τεχνολογία είναι ένα εργαλείο το οποίο το χρησιμοποιούν άνθρωποι. Εντός αυτών των ορίων μπορείς να πεις πως χρησιμοποίησες μια τεχνολογία με ηθικό τρόπο ή με ανήθικο τρόπο. Από μόνη της η τεχνολογία έχει μια ουδετερότητα. Εμείς κρίνουμε τον χρήστη».

-Ποιοι θέτουν τα όρια στην ηθική της τεχνολογίας; «Υπάρχουν τα ηθικά και τα νομικά όρια. Αλλά όταν αναφερόμαστε στα ηθικά όρια, μιλάμε για ανθρώπους. Και προσπαθούμε να κάνουμε τις πολιτικές και τους νόμους να ταιριάξουν με αυτά».

-Οι εταιρείες έχουν ηθική στην τεχνολογία; «Όταν κρίνουμε μια εταιρεία, μπορούμε να κοιτάξουμε τους δημιουργούς τους, αυτούς που βρίσκονται πίσω τους. Τις πράξεις της ομάδας των ιδιοκτητών, διαχειριστών και προγραμματιστών. Μπορούμε να τους κρίνουμε αν είναι εντός ηθικού πλαισίου. Υπάρχει ένας ανταγωνισμός για το ποιος θα αναπτύξει πρώτος τη γενική τεχνητή νοημοσύνη, γιατί αυτός που θα βγει στην αγορά πρώτος θα έχει και το προβάδισμα. Όταν η Microsoft “βούτηξε” με τρόπο… έτσι την OpenAI, πήρε ένα αβαντάζ στην αγορά με το ChatGPT και τώρα με τα καινούργια μοντέλα. Το ζητούμενο είναι μην αφήσουμε τον ανταγωνισμό να οδηγήσει σε ελάττωση της ασφάλειας. Να αναπτύξουμε κάτι το οποίο δεν είναι ελεγχόμενο ή προβλέψιμο. Η κόκκινη γραμμή που δεν πρέπει να ξεπεράσεις είναι πως κατέστρεψες ανθρώπους ή την ανθρωπότητα, γιατί ήθελες να πλουτίσεις γρηγορότερα».

-Η τεχνητή νοημοσύνη έχει ηθική; «Ο τρόπος με τον οποίο η δικιά μας ηθική υπόσταση και η κρίση λειτουργεί στον εγκέφαλό μας και τους νευρώνες μας, μπορεί να υπάρξει ψηφιακά; Θα πρέπει να φροντίσουμε να έχουμε ανθρώπινη ηθική. Να υπάρξουν τεχνολογίες επέκτασης της ήδη υπάρχουσας ηθικής κρίσης του ανθρώπου. Να μπορέσουμε να πάρουμε νέα δεδομένα και να τα υπολογίσουμε. Η κρίση πρώτα δημιουργείται στον εγκέφαλο και μετά μετατρέπεται σε συναίσθημα. Το ηθικό προηγείται του συναισθηματικού. Δείτε το με ένα πείραμα σκέψης: πρώτα θα πεις “αυτό ήταν ηθικά ανεπίτρεπτο” και μετά θα θυμώσεις, θα στεναχωρηθείς. Η κρίση, ουσιαστικά, είναι ανεξάρτητη σε αυτόν τον τομέα».

-Η τεχνητή νοημοσύνη απειλεί τον άνθρωπο; «Δεν πρέπει να το δούμε τελείως παθητικά: “Αμάν, κάτι θα μας συμβεί”. Εδώ είμαστε. Ενεργοί είμαστε. Σκεπτόμενοι είμαστε. Μπορούμε να συνεργαστούμε, να προλάβουμε και να προβλέψουμε κάποια πράγματα. Γιατί να την αφήσουμε να κατευθυνθεί σε κάτι που θα φέρει σε κίνδυνο τον απλό καθημερινό κόσμο ή την ανθρωπότητα ολόκληρη, ενώ έχουμε τα μέσα να την κατευθύνουμε από αυτό το αποτέλεσμα; Η αδιαφορία και η μη ενασχόληση μπορούν να αυξήσουν τον κίνδυνο».

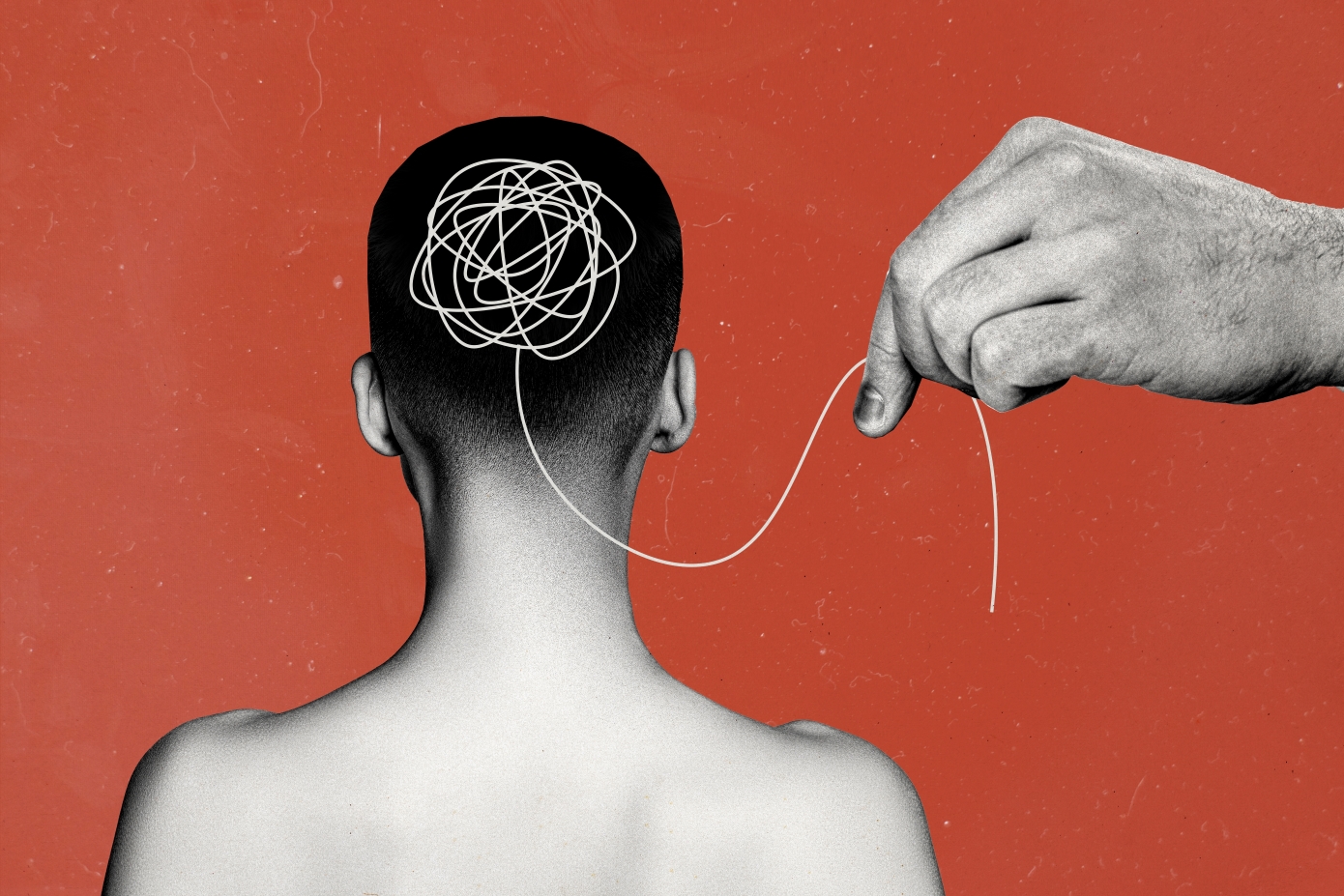

-Τι είναι αφυπνισμένη αλγοκρατία; «Έχουμε αυτές τις τεχνολογίες που θα μπορούσαν να χρησιμοποιηθούν για περισσότερη ελευθερία για να κάνουμε τον κόσμο πιο δημιουργικό – να έχει περισσότερες επιλογές, περισσότερη κοινωνικότητα. Και έχουν χρησιμοποιηθεί με τέτοιον τρόπο που φέρνουν την ανελευθερία. Αν ανοίξεις συζήτηση για κάποια θέματα με την τεχνητή νοημοσύνη της Microsoft ή της Google, ενδέχεται να συναντήσεις ένα τείχος για το ποια θέματα είναι συζητήσιμα και με ποιον τρόπο παρουσιάζονται. Είναι μια μορφή εξουσίας, ανεπίσημη. Εξουσίας και περιορισμού. Από την άλλη πλευρά, το Grok xAI, του Μασκ, κινείται προς την κατεύθυνση του να λες κάτι, αν έχεις την ελευθερία του λόγου, εφόσον είναι εντός πλαισίου νομιμότητας στη χώρα σου. Με σκιώδη τρόπο, αλγοριθμικά, το δικό σου το post, ενώ εσύ θα το βάλεις, θα περιοριστεί ποιος θα το διαβάσει. Ο χρήστης μπορεί να μην το καταλάβει ποτέ – δεν έρχεται ειδοποίηση ή εξήγηση έτσι κι αλλιώς. Έτσι, εκτός του ότι ο χρήστης περιορίζεται, κατευθύνεται. Γιατί; Γιατί ο καθένας από εμάς θέλει να διαβάζονται αυτά που αναρτά στα social media. Οπότε, θα προσαρμόσεις τον λόγο σου; Ουσιαστικά εξοστρακίστηκες που λέγαμε στην αρχαία Ελλάδα, αλλά χωρίς ψηφοφορία».

-Πώς λειτουργεί η ψηφιακή φυλακή; «Όταν θα αρχίσεις να λες κάποια πράγματα σαν κι αυτά που συζητάμε, βαράνε τα λαμπάκια στον αλγόριθμο – με λέξεις-κλειδιά, με τον κομισάριο στην επιτροπή ασφαλείας να χαρακτηρίζει τον λόγο σου μη ασφαλή και μη αποδεκτό από αυτά που έχει αποφασίσει η εταιρεία, βγαίνει ο βούρδουλας. Μπαίνεις στην ψηφιακή φυλακή, αν θεωρηθεί πως έχεις προβληματικές απόψεις και συμπεριφορά. Έναν ελαφρύ, σκιώδη περιορισμό, αν δεν ενοχλείς πολύ. Σε μπλοκάρουν, σου κλείνουν τον λογαριασμό και μετά από δυο τρεις μήνες σου δίνουν την ευκαιρία να μετανοήσεις και να βγεις ουσιαστικά πίσω στον κοινωνικό ψηφιακό περίγυρο απολογούμενος. Και θα σε έχουν στον νου τους».

Ακούστε το podcast με τον Παναγιώτη Σαραντέα