Ο Μο Γκόνταντ, ειδικός στην τεχνητή νοημοσύνη (AI) και πρώην επικεφαλής επιχειρήσεων στο Google X, στέλνει μια τρομακτική προειδοποίηση για τη χρήση και τους κινδύνους της νέας τεχνολογίας. Η ανησυχία του για την ταχεία άνοδο της τεχνητής νοημοσύνης είναι τόσο μεγάλη που προτρέπει τους ανθρώπους να μην κάνουν παιδιά, ενώ άλλοι ειδικοί εξετάζουν το σενάριο της «AI Doomsday», την ημέρα της «Αποκάλυψης» της τεχνητής νοημοσύνης.

«Ειλικρινά οι κίνδυνοι είναι τόσο ισχυροί, που εξετάζοντας όλες τις άλλες απειλές για την ανθρωπότητα, νομίζω πως οι άνθρωποι θα πρέπει να αποφύγουν να κάνουν παιδιά εάν ακόμη δεν έχουν γίνει γονείς», δήλωσε μιλώντας στον Steven Bartlett και στο podcast «το ημερολόγιο ενός CEO».

Όπως υπογραμμίζει το euronews, δεν είναι η πρώτη φορά που στελέχη της βιομηχανίας της τεχνολογίας εκδίδουν μια σαφή προειδοποίηση για τους μεγάλους κινδύνους της τεχνητής νοημοσύνης. Ισχυρά πρόσωπα της τεχνολογίας, όπως ο Έλον Μασκ και ο συνιδρυτής της Aplle, Steve Wozniak, αλλά και πολλοί άλλοι επιχειρηματίες και ειδικοί του χώρου υπέγραψαν πρόσφατα μια ανοιχτή επιστολή ζητώντας να «παγώσουν» οι καινοτομίες για λίγο καιρό, ώστε η βιομηχανία αλλά και οι ίδιοι οι χρήστες να αποκτήσουν χρόνο για να επεξεργαστούν τις τελευταίες εξελίξεις.

«Ο μετριασμός του κινδύνου εξαφάνισης από την τεχνητή νοημοσύνη θα πρέπει να αποτελεί παγκόσμια προτεραιότητα μαζί με άλλους κινδύνους κοινωνικής κλίμακας, όπως οι πανδημίες και ο πυρηνικός πόλεμος», ανέφερε σε ανακοίνωσή του το Κέντρο για την Ασφάλεια της Τεχνητής Νοσημοσύνης.

Τις εν λόγω ανησυχίες ενστερνίστηκαν με ανοιχτή επιστολή και εκατοντάδες ηγέτες του κλάδου. Ο ίδιος ο Σαμ Άλτμαν, ο διευθύνων σύμβουλος της Open AI, της εταιρείας που δημιούργησε το ChatGPT φέρνοντας επανάσταση στο χώρο της τεχνητής νοημοσύνης, έχει προειδοποιήσει για «υπαρξιακό κίνδυνο», τονίζοντας πως «ένας από τους μεγαλύτερους φόβους μου, είναι μήπως προκαλέσουμε σημαντικές ζημιές στην κοινωνία. Αν αυτή η τεχνολογία βαδίσει στον λάθος δρόμο, μπορεί να πάει αρκετά μακριά».

«Δεν έχει υπάρξει ποτέ στην ιστορία της ανθρωπότητας τόσο τέλεια καταιγίδα», τονίζει ο Μο Γκόνταντ. «Οικονομία, γεωπολιτική, υπερθέρμανση του πλανήτη, κλιματική αλλαγή και τώρα η ιδέα της τεχνητής νοημοσύνης. Αυτή είναι μια τέλεια καταιγίδα, η απόλυτη αβεβαιότητα… Πότε ξανά δεν ήταν πιο έντονη. Αν αγαπούσατε πραγματικά τα παιδιά σας, θα θέλατε πραγματικά να τα εκθέσετε σε όλα αυτά;». Και αυτή η «τέλεια καταιγίδα» ενισχύεται από τον ανταγωνισμό των εταιρειών τεχνολογίας, που έχουν επιδοθεί σε μια κούρσα για την ηγεμονία στη νέα τεχνολογική εποχή.

«Έχω περάσει την καριέρα μου γοητευμένος από τον ρόλο που παίζει η τεχνολογία και τώρα η μεγαλύτερη πρόκληση που έχει αντιμετωπίσει ποτέ η ανθρωπότητα είναι μπροστά μας», είπε και πρόσθεσε:

«Η τεχνητή νοημοσύνη είναι το αποκορύφωμα της τεχνολογικής προόδου και πιστεύω ότι θα είναι άνευ προηγουμένου στον καθορισμό του τρόπου με τον οποίο διαμορφώνεται ο κόσμος». «Η πολυπλοκότητα της ψηφιακής νοημοσύνης είναι τέτοια που έχει γίνει αυτόνομη. Είναι ζωτικής σημασίας να μείνουμε συντονισμένοι στο πώς θα πρέπει να γίνεται αυτό, διαφορετικά κινδυνεύουμε να μείνουμε πίσω», κατέληξε.

Το σενάριο της «ΑΙ Doomsday»

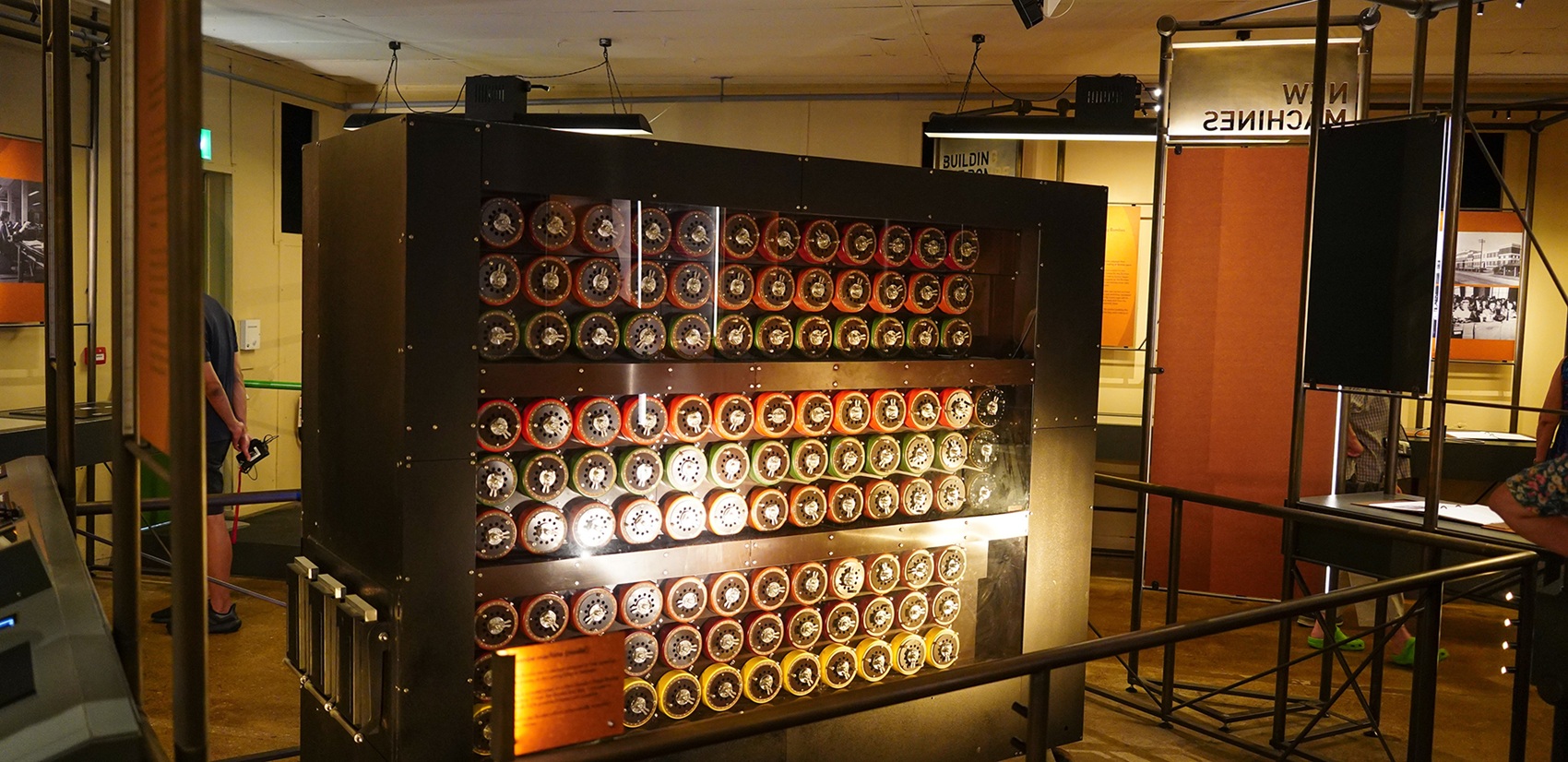

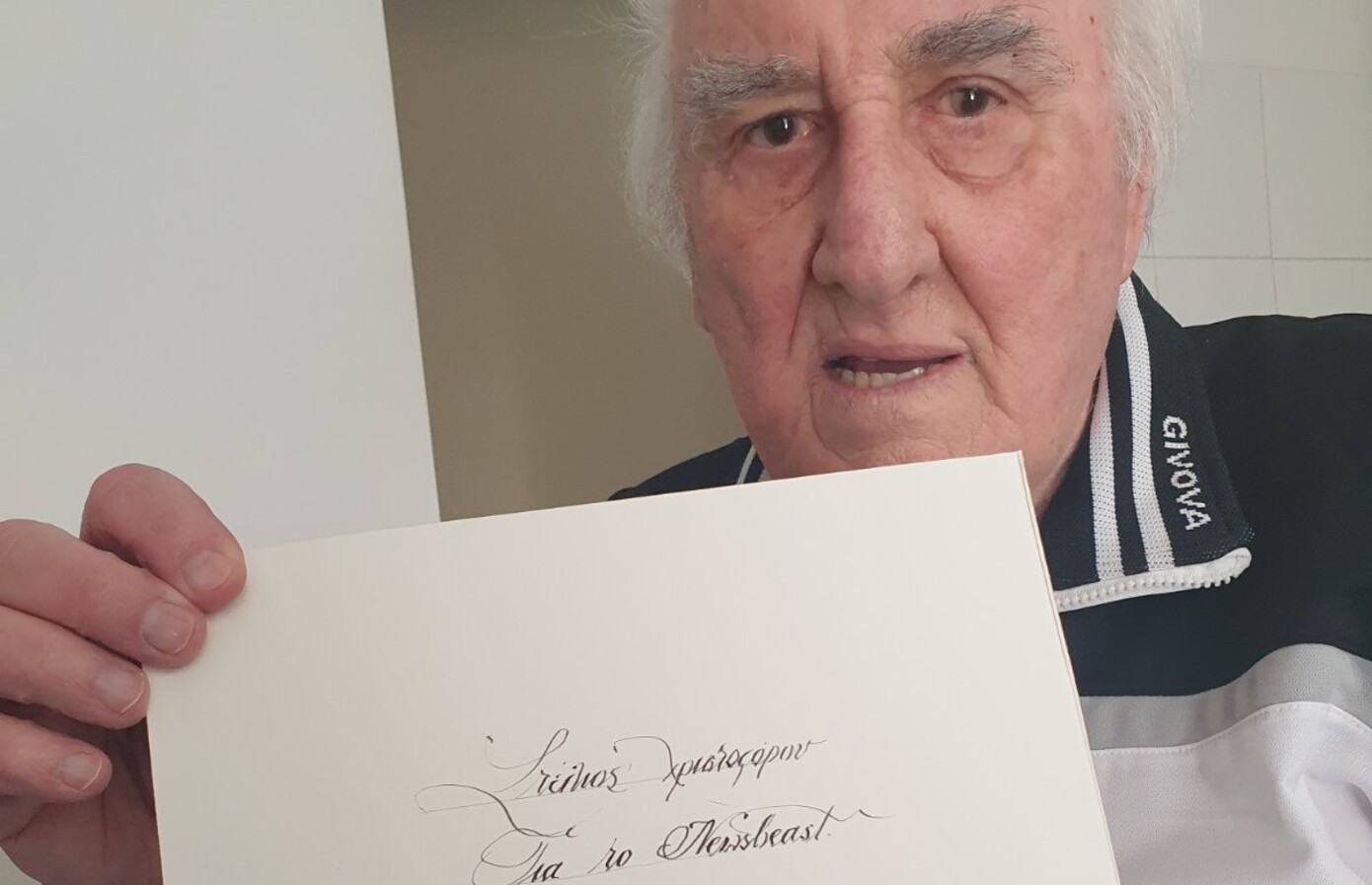

Όταν αναφερόμαστε στους κινδύνους της τεχνητής νοημοσύνης πολλοί φέρνουν στο μυαλό τους κινηματογραφικές δυστοπίες επιστημονικής φαντασίας. Η πραγματικότητα, σημειώνουν οι ειδικοί, θα είναι λιγότερο κινηματογραφική και θα σχετίζεται με μια υφέρπουσα επιδείνωση θεμελιωδών πτυχών των κοινωνιών. Το ίδιο το ChatGPT, σε συνέντευξή στο Newsbeast, είχε προειδοποιήσει πως ο κίνδυνος δεν προκύπτει από την ίδια την τεχνολογία αλλά από την κακόβουλη χρήση της από ανθρώπους.

Αυτό επισημαίνουν και οι ειδικοί. Η Τζέσικα Νιούμαν, διευθύντρια της Πρωτοβουλίας Ασφάλειας Τεχνητής Νοημοσύνης του Πανεπιστημίου της Καλιφόρνια στο Μπέρκλεϋ, μιλώντας στον Guardian, υπογράμμισε πως «η ανησυχία δεν προκύπτει από μια τεχνητή νοημοσύνη που θα αποκτήσει κάποιου είδους κακόβουλη επιθυμία». Ο κίνδυνος προέρχεται από κάτι πολύ πιο απλό: Από τον τρόπο που οι άνθρωποι θα αξιοποιήσουν την τεχνητή νοημοσύνη. Είτε γιατί επιθυμούν να προκαλέσουν κάτι κακό, είτε γιατί θα ενσωματώσουν σε υπέρμετρο βαθμό συστήματα τεχνητής νοημοσύνης – ακόμη και ανακριβή με εγγενείς αδυναμίες – σε όλο και περισσότερους τομείς της κοινωνίας.

Εν ολίγοις, η ακραία χρήση της τεχνητής νοημοσύνης έχει την ικανότητα να αποσταθεροποιεί κοινωνίες χωρίς να πάρει τα όπλα. Για παράδειγμα με τη μορφή της παραπληροφόρησης, διαβρώνεται η κοινή κατανόηση της αλήθειας και της εγκυρότητας των πληροφοριών. Μάλιστα η παραπληροφόρηση – είτε ως ανακρίβεια, είτε ως κακόβουλη διάδοση με σκοπό την παραπλάνηση – θα μπορούσε να διαιωνίζεται, καθώς τα τρέχοντα μοντέλα τεχνητής νοημοσύνης θα δημιουργούν διαρκώς ελαττωματικά σύνολα δεδομένων από τα οποία θα γίνεται η εκμάθηση των μελλοντικών μοντέλων.

Μεγάλα γλωσσικά μοντέλα όπως το ChatGPT είναι επιρρεπή σε ένα φαινόμενο που ονομάζεται «παραισθήσεις», στο οποίο επαναλαμβάνονται κατασκευασμένες ή ψευδείς πληροφορίες. Υπάρχουν άνθρωποι που λένε ότι οι κίνδυνοι της τεχνητής νοημοσύνης υπερεκτιμώνται, αλλά στον κόσμο των πληροφοριών έχει εκπληκτικό αντίκτυπο, επισημαίνουν ειδικοί, τονίζοντας πως το ερώτημα που τίθεται είναι εάν μπορούμε να καταλάβουμε πραγματικά τι είναι αλήθεια και τι όχι και πως επαληθεύουμε αυτό που βλέπουμε στο διαδίκτυο.

Τα μέσα κοινωνικής δικτύωσης, που βασίζονται σε αλγόριθμούς, έχουν ήδη δώσει ένα μάθημα, επιβεβαιώνοντας την αδυναμία να ελεγχθεί αυτό το φαινόμενο, αλλά και τις επιπτώσεις που έχει. Πέρα από την παραπληροφόρηση, η τεχνητή νοημοσύνη μπορεί να χρησιμοποιηθεί για τη χειραγώγηση και τον έλεγχο ανθρώπων,για αυτόνομα οπλικά συστήματα ενώ παράλληλα επιφέρει ένα βίαιο μετασχηματισμό στην αγορά εργασίας, καταλαμβάνοντας τεράστιο αριθμό θέσεων.