Ανησυχία εκφράζουν οι ειδικοί για την αυξανόμενη χρήση φωτογραφιών που δείχνουν σκηνές ακραίας φτώχειας, οι οποίες έχουν παραχθεί με τη χρήση τεχνητής νοημοσύνης και εμφανίζονται σε καμπάνιες οργανώσεων.

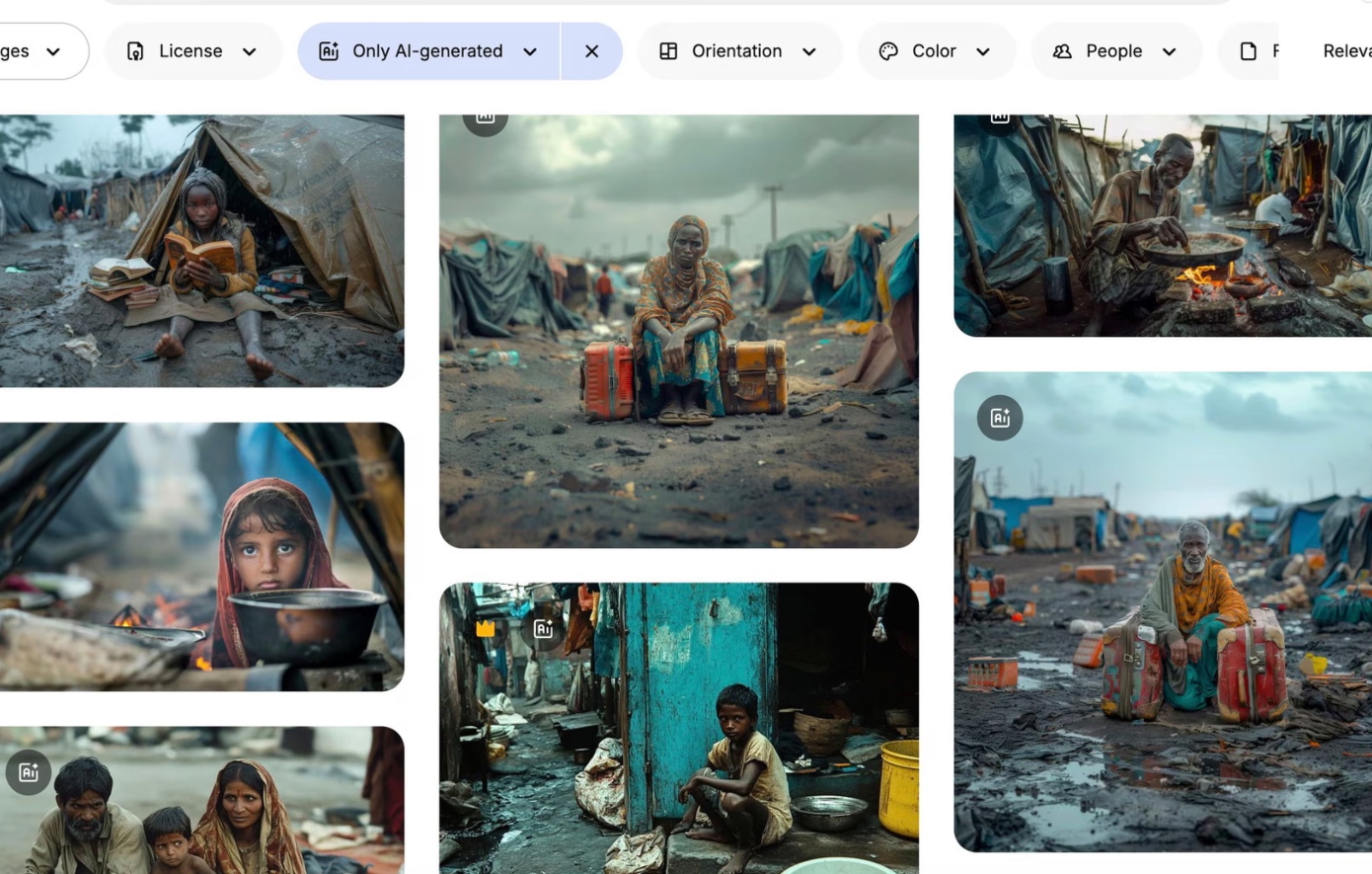

Ιστότοποι με φωτογραφίες έχουν όλο και περισσότερες φωτογραφίες που απεικονίζουν εικόνες ακραίας φτώχειας ή επιζώντες σεξουαλικής βίας, οι οποίες, ωστόσο, δεν δείχνουν πραγματικά πρόσωπα, καθώς έχουν δημιουργηθεί με τεχνητή νοημοσύνη.

Και, την ίδια ώρα, όλο και περισσότερες ΜΚΟ και διεθνείς οργανώσεις στρέφονται στη χρήση τέτοιων φωτογραφιών, υποστηρίζοντας πως είναι φθηνότερες και απαλλαγμένες από ζητήματα που αφορούν άδειες και συναινέσεις.

Μάλιστα, ειδικοί μιλούν για «πορνογραφία της φτώχειας» (poverty porn), αναφερόμενοι στο πώς τέτοιες εικόνες παρουσιάζουν τη φτώχεια ή, ευρύτερα, τον ανθρώπινο πόνο, με τρόπο εμφανώς δραματοποιημένο, με στόχο να προκαλέσουν οίκτο, συγκίνηση ή ενοχή στο κοινό. Ο όρος συχνά χρησιμοποιείται για να περιγράψει καμπάνιες από ΜΚΟ και φιλανθρωπικές οργανώσεις, όπου παρουσιάζονται υπερβολικά στερεοτυπικές σκηνές, όπως πεινασμένα παιδιά, βρόμικα ρούχα ή ραγισμένα τοπία, για να τραβήξουν την προσοχή ή να συγκεντρώσουν δωρεές.

Η κριτική που ασκείται σε αυτές τις πρακτικές συνήθως στρέφεται στο πώς αναπαράγουν στερεότυπα και ενισχύουν τις κοινωνικές προκαταλήψεις, για να προκαλέσουν συναισθηματική αντίδραση.

Με την είσοδο της τεχνητής νοημοσύνης, μάλιστα, ο όρος αποκτά νέα διάσταση, καθώς ψεύτικες, συνθετικές εικόνες δημιουργούνται για να αναπαράγουν τα ίδια στερεότυπα, χωρίς καν να υπάρχει αληθινό πρόσωπο ή συναίνεση πίσω από το στιγμιότυπο.

Στην εποχή της τεχνητής νοημοσύνης, εικόνες που απεικονίζουν παιδιά μέσα στη λάσπη, γυναίκες-θύματα βίας και σκηνές ακραίας φτώχειας δεν προέρχονται πάντα από την πραγματικότητα, αλλά από αλγόριθμους, προκαλώντας ανησυχία στους ειδικούς για μια νέα εποχή «πορνογραφίας της φτώχειας»..

«Χρησιμοποιούνται παντού», είπε ο Νόα Άρνολντ από τη Fairpicture, μια ελβετική οργάνωση, σύμφωνα με τον Guardian. «Κάποιοι χρησιμοποιούν ενεργά εικόνες τεχνητής νοημοσύνης, ενώ άλλοι πειραματίζονται».

Ο Αρσένιι Αλενίτσεφ, ερευνητής στο Ινστιτούτο Τροπικής Ιατρικής της Αμβέρσας, που μελετά την παραγωγή εικόνων παγκόσμιας υγείας, δήλωσε:

«Οι εικόνες αναπαράγουν την εικόνα της φτώχειας -παιδιά με άδεια πιάτα, ξεραμένη γη, στερεοτυπικά πλάνα».

«Πορνογραφία της φτώχειας 2.0»

Ο Αλενίτσεφ έχει συγκεντρώσει περισσότερες από 100 εικόνες ακραίας φτώχειας που δημιουργήθηκαν με ΑΙ και χρησιμοποιούνται από άτομα ή ΜΚΟ σε καμπάνιες κατά της πείνας ή της σεξουαλικής βίας. Οι εικόνες που μοιράστηκε με τον Guardian δείχνουν υπερβολικές, στερεοτυπικές σκηνές: παιδιά μαζεμένα μέσα σε βρόμικο νερό, ένα κορίτσι στην Αφρική με νυφικό και δάκρυ στο μάγουλο. Σε άρθρο του στο Lancet Global Health, χαρακτηρίζει αυτές τις εικόνες ως «πορνογραφία της φτώχειας 2.0», εννοώντας, προφανώς, πως πρόκειται για ένα γνωστό φαινόμενο, το οποίο περνά σε μια νέα εποχή με τη χρήση της τεχνολογίας.

Αν και είναι δύσκολο να μετρηθεί η έκταση του φαινομένου, ο Αλενίτσεφ και άλλοι λένε ότι η χρήση τέτοιων εικόνων αυξάνεται, κυρίως λόγω ανησυχιών για τη συναίνεση και του χαμηλού κόστους. Ο Άρνολντ τόνισε ότι οι περικοπές στη χρηματοδότηση των ΜΚΟ στις ΗΠΑ έχουν επιδεινώσει την κατάσταση.

«Είναι σαφές ότι διάφοροι οργανισμοί αρχίζουν να προτιμούν συνθετικές εικόνες αντί για πραγματικές φωτογραφίες, επειδή είναι φθηνές και δεν χρειάζεται να ασχοληθούν με άδειες και συναίνεση», είπε ο Αλενίτσεφ.

Σήμερα, δεκάδες AI εικόνες ακραίας φτώχειας εμφανίζονται σε δημοφιλείς ιστότοπους όπως το Adobe Stock Photos και το Freepik, με λεζάντες όπως: «Ρεαλιστικό παιδί σε καταυλισμό προσφύγων», «Ασιάτες μαθητές κολυμπούν σε ποτάμι γεμάτο σκουπίδια», «Λευκός εθελοντής παρέχει ιατρική βοήθεια σε μαύρα παιδιά αφρικανικού χωριού».

«Είναι φυλετικά φορτισμένες. Δεν θα έπρεπε καν να επιτρέπεται η δημοσίευσή τους -αναπαράγουν τα χειρότερα στερεότυπα για την Αφρική ή την Ινδία», είπε ο Αλενίτσεφ.

Ο Χοακίν Αμπέλα, διευθύνων σύμβουλος του Freepik, δήλωσε ότι η ευθύνη για τη χρήση τέτοιων εικόνων βαραίνει τους χρήστες και όχι τις πλατφόρμες. Οι εικόνες, εξήγησε, παράγονται από την παγκόσμια κοινότητα δημιουργών του Freepik, που λαμβάνουν αμοιβή όταν κάποιος αγοράζει τη δουλειά τους.

Πρόσθεσε ότι η εταιρεία του έχει προσπαθήσει να περιορίσει προκαταλήψεις που εντόπισε αλλού στη βιβλιοθήκη φωτογραφιών της, «εισάγοντας περισσότερη ποικιλομορφία» σε κατηγορίες όπως «δικηγόροι» και «CEO».

Ωστόσο, σημείωσε: «Είναι σαν να προσπαθείς να στεγνώσεις τον ωκεανό. Κάνουμε προσπάθειες, αλλά αν οι πελάτες σε όλο τον κόσμο ζητούν συγκεκριμένες εικόνες, δεν μπορείς να κάνεις πολλά».

«Φαίνεται πιο εύκολο να χρησιμοποιείς έτοιμες εικόνες ΑΙ χωρίς συναίνεση, επειδή δεν απεικονίζουν αληθινούς ανθρώπους»

Στο παρελθόν, μεγάλες φιλανθρωπικές οργανώσεις έχουν χρησιμοποιήσει εικόνες τεχνητής νοημοσύνης στις καμπάνιες τους. Το 2023, το ολλανδικό τμήμα της Plan International κυκλοφόρησε βίντεο κατά των παιδικών γάμων με AI εικόνες: ένα κορίτσι με μαυρισμένο μάτι, έναν ηλικιωμένο άνδρα και μια έγκυο έφηβη.

Την ίδια χρονιά, ο ΟΗΕ ανάρτησε στο YouTube βίντεο με AI «αναπαραστάσεις» σεξουαλικής βίας σε εμπόλεμες ζώνες, συμπεριλαμβανομένης μιας μαρτυρίας γυναίκας από το Μπουρούντι, που περιέγραφε τον βιασμό της από τρεις άνδρες το 1993. Το βίντεο κατέβηκε μετά από επικοινωνία του Guardian με τον ΟΗΕ.

Εκπρόσωπος των Ειρηνευτικών Δυνάμεων του ΟΗΕ είπε: «Το βίντεο, που δημιουργήθηκε πάνω από έναν χρόνο πριν, αφαιρέθηκε καθώς κρίθηκε ότι δείχνει ακατάλληλη χρήση της τεχνητής νοημοσύνης και ενδέχεται να διαταράξει την ακεραιότητα των πληροφοριών, αναμειγνύοντας πραγματικό και συνθετικό περιεχόμενο. Ο ΟΗΕ παραμένει δεσμευμένος στη στήριξη των θυμάτων σεξουαλικής βίας σε συγκρούσεις».

Ο Άρνολντ σημείωσε ότι η αύξηση της χρήσης τέτοιων εικόνων έρχεται μετά από χρόνια συζητήσεων στον χώρο για την ηθική απεικόνιση της φτώχειας και της βίας. «Φαίνεται πιο εύκολο να χρησιμοποιείς έτοιμες εικόνες ΑΙ χωρίς συναίνεση, επειδή δεν απεικονίζουν αληθινούς ανθρώπους», είπε.

Η σύμβουλος επικοινωνίας ΜΚΟ Κέιτ Κάρντολ ανέφερε πως αυτές οι εικόνες τη φοβίζουν, θυμίζοντάς της τις παλιές συζητήσεις για το “poverty porn”:

«Με λυπεί που ο αγώνας για πιο ηθική εκπροσώπηση ανθρώπων που βιώνουν τη φτώχεια έχει φτάσει πλέον και στο μη πραγματικό».

Τα εργαλεία τεχνητής νοημοσύνης έχουν επανειλημμένα βρεθεί να αναπαράγουν -ή και να ενισχύουν- κοινωνικές προκαταλήψεις. Η διάδοση τέτοιων μεροληπτικών εικόνων στην επικοινωνία της παγκόσμιας υγείας μπορεί να επιδεινώσει το πρόβλημα, καθώς οι εικόνες αυτές θα καταλήξουν να εκπαιδεύουν τα επόμενα ΑΙ μοντέλα, ενισχύοντας έτσι τα στερεότυπα.

Εκπρόσωπος της Plan International ανέφερε ότι η ΜΚΟ έχει πλέον υιοθετήσει πολιτική που αποτρέπει τη χρήση ΑΙ για την απεικόνιση παιδιών, διευκρινίζοντας ότι η καμπάνια του 2023 είχε στόχο να προστατεύσει την ιδιωτικότητα και την αξιοπρέπεια των πραγματικών κοριτσιών.